-

产品及解决方案

-

服务

-

产品及解决方案

-

服务

-

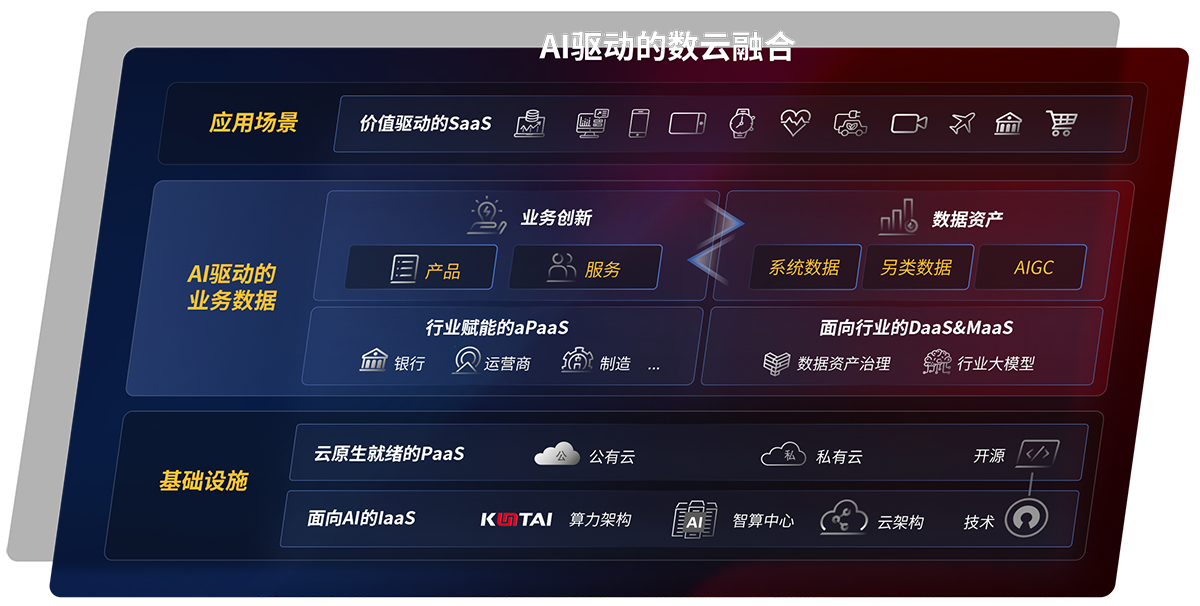

云原生产品及应用平台

- 5001拉斯维加斯研云 研制一体化工业互联网解决方案

- 磐云 云原生PaaS平台

- 5001拉斯维加斯云印 数字化文印管理平台

- 5001拉斯维加斯视讯 融合会议服务平台及应用

-

云服务

-

AI算力服务器

AI算力服务器 -

安全产品了解更多

安全产品了解更多

京公网安备 11010802037792号

京公网安备 11010802037792号